注意力是啥(什么叫注意力)

注意力是啥(什么叫注意力),本文通过数据整理汇集了注意力是啥(什么叫注意力)相关信息,下面一起看看。

丰富的色彩来自凹陷的太阳穴。

量子比特报告|微信官方账号QbitAI

Transformer跨界计算机视觉取得了一些不错的成果,但在大多数情况下,仍然落后于最先进的卷积网络。

现在,谷歌提出了一个叫CoAtNets.的模型,从名字可以看出,它是Convolution+Attention.的组合模型

该模型在ImageNet数据集上达到了86.0%top-1的精度,在JFT数据集上达到了89.77%的精度,性能优于现有的所有卷积网络和Transformer!

卷积结合自注意,更强的泛化能力和更高的模型容量他们是如何决定将卷积网络与Transformer结合起来构建新模型的?

首先,研究人员发现卷积网络和Transformer在机器学习的两个基本方面各有优势:——泛化和模型容量。

由于卷积层具有很强的诱导偏向性,卷积网络模型具有更好的泛化能力和更快的收敛速度,而具有注意机制的变换器具有更高的模型容量,可以受益于大数据集。

然后通过卷积层和关注层的结合,可以同时获得更好的泛化能力和更大的模型容量!

那么,关键问题是:如何将它们有效地结合起来,在准确性和效率之间取得更好的平衡?

研究人员还发现,普通的depth wise卷积可以用简单的相对注意合并到注意层!

因此,他们将CoAtNets的实现分为两步:

1.卷积和自注意结合在一个基本计算块中;

2.垂直堆叠不同类型的计算块(垂直布局设计),形成一个完整的网络。

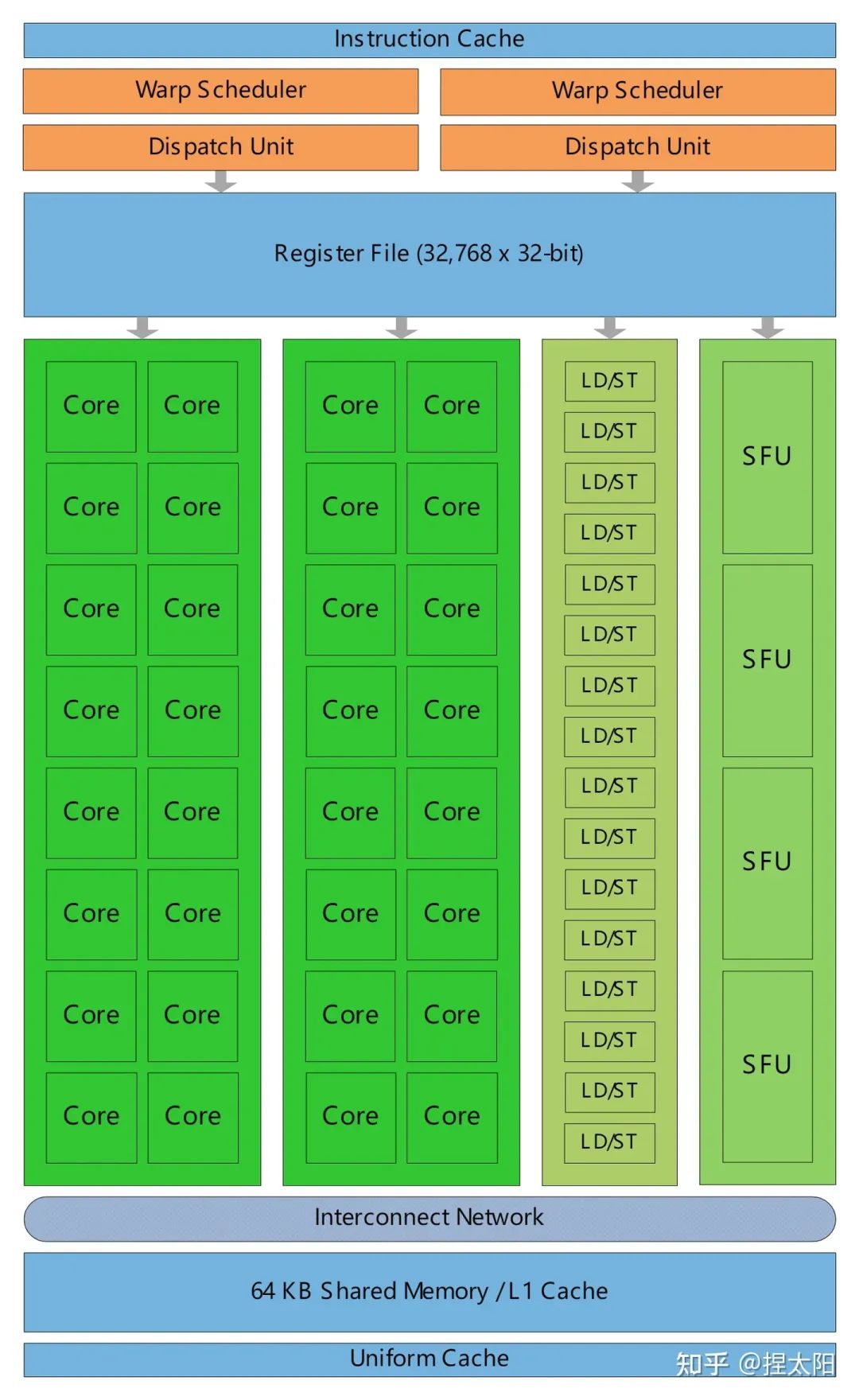

具体实现首先,因为Transformer和MBConv中的FFN模块都采用了反向瓶颈,深度卷积和自我注意都可以通过预定义感受野CoAtNets主要采用MBConv卷积块.中的加权和来表示

具体来说,卷积依靠一个固定的核心从本地感受野收集信息:

相比之下,自注意允许感受野成为整个空间位置,并根据对之间的重正化成对相似性来计算权重(xi,xj):

在以最佳形式组合它们之前,研究人员比较了它们的理想特征。

结合深度卷积和自我注意的理想模型需要具备上述三个特征,研究者的实现方法很简单:在Softmax归一化之前或之后对全局静态卷积核和自适应注意矩阵求和。

卷积和注意力结合后,就可以开始叠全网了。

就空间大小而言,全球背景具有次要的复杂性。如果将上述公式中的相对注意直接应用于原始图像输入,普通尺寸的图像会出现像素过多,从而导致计算速度过慢.

因此,为了建立一个在实践中可行的模型,研究人员选择在featuremap达到可管理的水平后,进行一些下采样,以减少空间大小,然后使用全局相对注意。

其中,下采样可以通过像ViT那样的正步幅(如16x16)的convolutionstem或像ConvNets.那样的累进池多级网络来实现

研究人员根据上述两种方法堆叠了五种变体:C-C-C、C-C-T、C-C-T-T和C-T-T-T和VIT,其中C和T分别代表卷积和变换。

为了做出选择,他们进行了对比实验,选出了泛化能力和模型容量最好的两个模型:C-C-T-T和C-T-T-T,最终选择了迁移性能更好的C-C-T-T。

至此,完整的CoAtNets模型已经实现。

NO.1的top-1精度事实上,将卷积和自注意结合起来用于计算机视觉的想法并不新鲜,但之前的一些方法通常会带来额外的计算成本和其他问题。

它们的相对注意力的实例化是深度卷积和基于内容的注意力的自然结合,加上优中选优的垂直布局设计,以及新模型CoAtNets引起的额外成本最小。

我们来看看具体的实验数据:

仅使用ImageNet-1K数据集的实验结果表明,CoAtNet不仅优于ViT变体,而且可与最好的仅卷积结构(高效网络-V2和nfnet)相媲美。

从上表和下图也可以看出,当ImageNet-21K用于前期训练时,CoAtNet的优势变得更加明显,比之前的所有机型都要好很多。

并且实现了最佳的CoAtNet变体。

rong>88.56%的top-1精度,而与之匹敌的ViT-H/14则需要在23倍大的JFT数据集上预先训练2.3倍规模的ViT才能达到88.55%的成绩。这标志着CoAtNet模型数据效率和计算效率的显著提高。

△ImageNet-21K?ImageNet-1K的参数精度最后,研究人员用JFT进一步评估了大规模数据集下的CoAtNet,发现它达到89.77%精度,超过ResNet最强变体NFNet-F4+排名第一,同时在TPU训练时间和参数计数方面提高了2倍效率。

作者介绍论文的四位作者全部来自谷歌大脑。

DaiZihang,本科清华大学工商管理专业,硕士卡内基梅隆大学计算机专业,博士卡内基梅隆大学计算机和哲学双学位。

刘寒骁,同为清华本科,卡内基梅隆大学计算机博士,谷歌大脑高级研究科学家,曾在DeepMind研究神经架构搜索。

QuocLe,这位大佬应该很多人都知道,斯坦福大学计算机科学博士毕业,吴恩达的学生,谷歌大脑的创始成员和AutoML的缔造者之一。

TanMingxing,北京大学博士毕业、康奈尔大学博士后。

论文地址:

—完—

量子位QbitAI·头条号签约

关注我们,第一时间获知前沿科技动态

更多注意力是啥(什么叫注意力)相关信息请关注本站。