探索GTX960在并行计算领域的实际应用与未来发展

如今,图形处理器(简称GPU)不仅局限于图像处理,更广泛运用于并行计算领域。中高端GPU型号如GTX960,具强大并行计算潜能。本篇文章深入研究GTX960在并行计算领域的实际运用及发展前景。

1.GTX960的基本特性

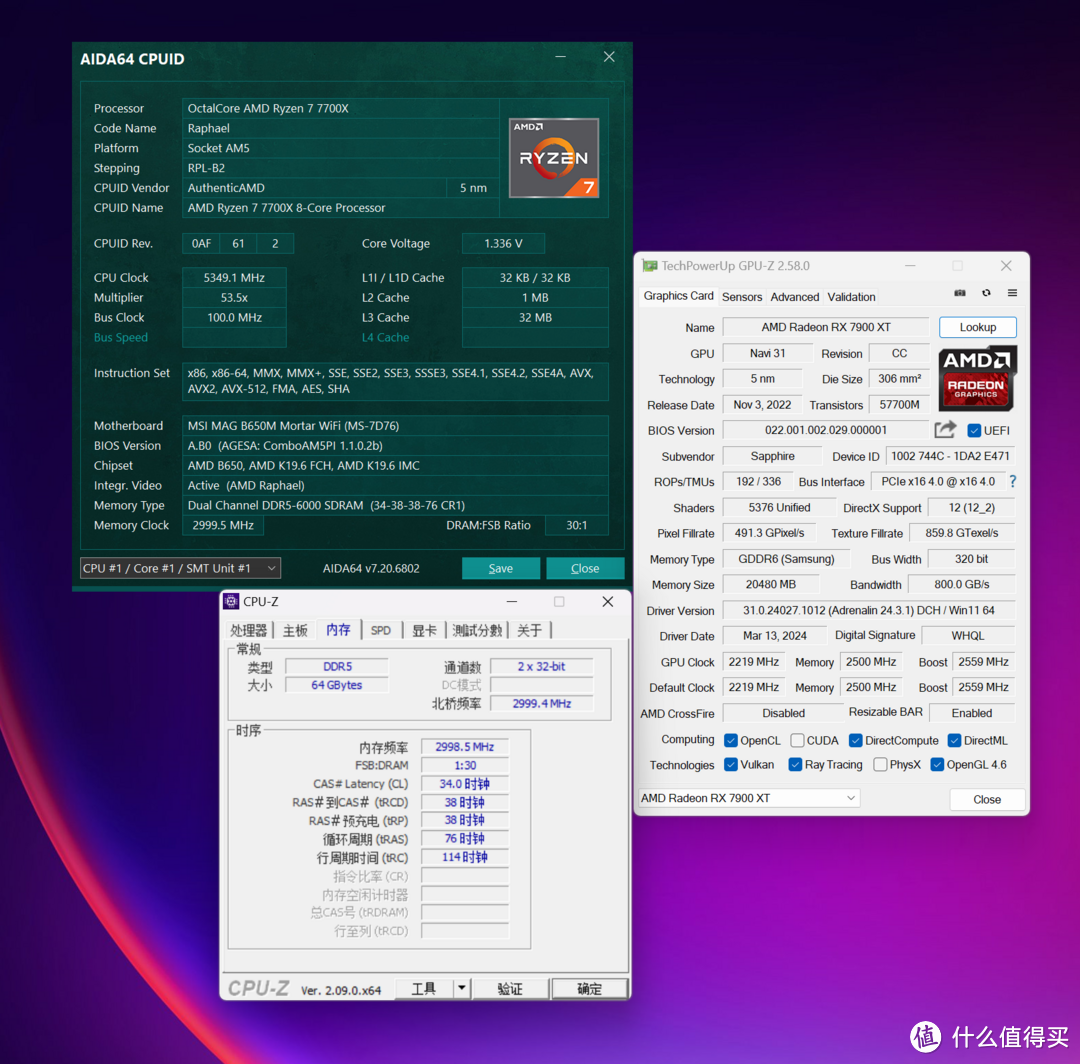

NVIDIAGTX960显卡乃是采用Maxwell结构设计的尖端产品,具有1024颗CUDA核心及1127MHz的高频率运行效率,峰值计算能力更达到惊人的2.3TFLOPs。同时,其搭载的2GBGDDR5显存以及128位的宽大内存总线宽度,令带宽显示到112GB/s,为并行运算奠定坚实基石。

GTX960这一优质游戏显卡,在图形处理性能上出类拔萃,但其非凡的并行运算潜能亦引起广泛关注。得益于众多的CUDA内核,它在并行运算任务中展示了巨大的潜力,尤其适用于需要大规模并行计算的科学研究、数据解析以及AI应用等领域。

除了具备优良的硬件规格外,GTX960在计算性能上的优势亦得益于NVIDIA所提供的CUDA平台及其相应工具的支持。该平台为开发人员提供了丰富的并行计算API以及工具库,使他们能够充分运用GTX960强大的计算能力,实现高效率的并行运算。

2.GTX960在科学计算中的应用

在科学研究中,采用配备GTX960显卡的计算机进行并行运算有助于加速解决复杂计算问题,如物理粒子模拟,生物基因组学分析,气象气候模拟及天气预测等。

得益于GTX960卓越的计算能力与亲民的价格,其已在科研机构及高校实验室等领域得到广泛运用。研究者可借助构建多GPU集群系统,实现计算性能的大幅提升,从而推动科学研究的快速发展。

3.GTX960在数据分析中的应用

以数据分析为例,GTX960可显著提升大规模数据处理与分析的效率及速度。例如,在金融行业中,GTX960能助力高频交易数据的实时分析与预测;在医疗领域,其可用于医学影像数据的精细处理与深度分析;而在市场营销方面,则可运用GTX960对用户行为数据进行深入挖掘与剖析。

面对日益庞大的数据规模与日趋复杂的数据分析要求,原有的CPU计算已难以为继,而GPU并行运算作为重要对策应运而生。GTX960作为一款具性价比优势的显卡,对提升数据分析效能具有显著价值。

4.GTX960在人工智能中的应用

当前,AI作为科技行业的重要话题正值火热,其中,GTX960在该领域的运用也是十分广泛。深度学习等AI算法需依赖大规模计算资源进行模型训练,而GTX960的并行处理能力恰恰为此提供了强有力的技术支撑。

在图像识别、语音识别的广泛领域,以及自然语言处理等关键环节中,GTX960的强大性能均能充分体现,助力模型训练及推理过程加快。借助CUDA深度学习库等先进工具,广大开发者可轻松将各类AI应用部署到GTX960平台之上。

5.GTX960的优势与劣势

虽然GTX960在并行运算方面具备诸多优点,但亦存在一定局限性。首要问题便是其算力相对有限,较之高端的Tesla系列显卡仍有差距,在应对大型且复杂的计算任务时或将面临性能瓶颈。此外,作为一款游戏显卡,GTX960在稳定性及可靠性上或许不及专业的计算卡。

然而,鉴于其较具竞争力的性能价格比以及亲民的售价,使得GTX960仍成为诸多科研机构、实验室及独立开发者的优先选择。对于非极端需求的性能环境,GTX960能够提供强大的计算能力以满足众多科学计算、数据分析乃至人工智能任务的需求。

6.未来发展趋势

科技进步与GPU技术成熟推动下,曾风靡全球的GTX960已面临市场淘汰趋势。然而,该显卡在并行计算方面的资深实战及丰富技术储备,必将对新一代产品研发产生深远影响。展望未来,我们有理由期待性能更为强大、效率更高的GPU产品,为并行计算领域注入新的活力与创新元素。

7.总结与展望

经过深入研究GTX960及并行计算技术,我们不仅掌握了该款显卡的基础性能及其适用环境,同时也洞察到GPU在并行计算领域的关键地位以及巨大潜能。虽然GTX960尚存部分局限性,但其在科学计算、数据分析乃至人工智能等多个领域的广泛应用,充分彰显了其独特的价值和优势。

得益于GPU技术的持续突破及广泛应用,GTX960及今后产品必将持续引领前沿,助力科技创新与社会进步。

针对GTX960的并行计算潜能,您有何看法?对于GPU未来发展,您又有怎样的期许和展望呢?